「2020.2」の記事一覧

Intel DevCloud for the Edge を使い倒す(その4)

Intel DevCloud for the Edge を使い倒す(その3)

Intel DevCloud for the Edge を使い倒す(その2)

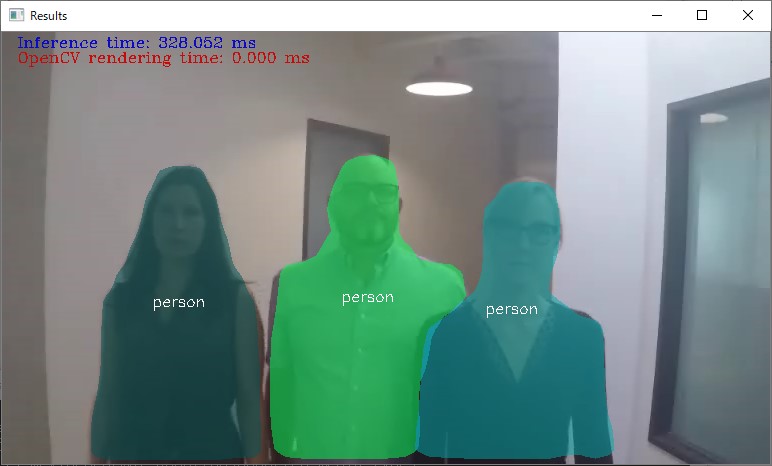

Instance Segmentation Demoの実行(Windows編)

Intel DevCloud for the Edge を使い倒す(その1)

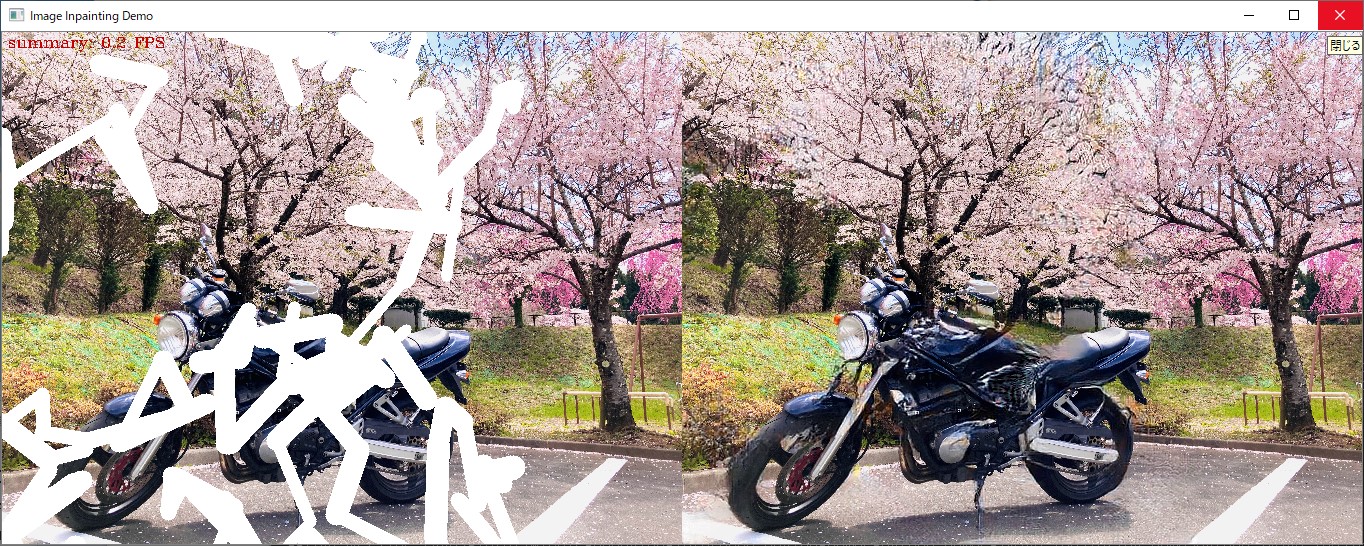

Image Inpainting Demoの実行(Windows編)

Intel DevCloud for the Edge

super resolution demoで動画を変換