本記事は、https://docs.openvinotoolkit.org/latest/_docs_install_guides_installing_openvino_windows.html を元に記述しています。元のページも参照してください。

- 2020.06.04追記:OpenVINO 2020.3 LTS Release も同様の手順で入る事を確認済です。

- 2020.10.19追記:OpenVINO 2021.1での手順も確認しました。(pythonのバージョン次第ですが、すんなり行かなかった内容を書いています)

インストールされるコンポーネント

| コンポーネント | 説明 |

| Model Optimizer | このツールは、人気のあるフレームワークでトレーニングされたモデルを、Intelツール、特に推論エンジンで使用可能な形式にインポート、変換、および最適化します。 注:人気のあるフレームワークには、Caffe *、TensorFlow *、MXNet *、およびONNX *などのフレームワークが含まれます。 |

| Inference Engine | ディープラーニングエンジン アプリケーション組み込みライブラリ |

| OpenCV | Intel Hardware用にコンパイルされたOpenCV |

| Inference Engine Samples | 推論エンジンを使用するためのコンソールデモアプリケーション |

| Demos | 特定のユースケースを解決するためにアプリケーションで推論エンジンを使用する方法を示す複数のコンソールアプリケーション |

| Additional Tools | モデルを操作するための一連のツール |

| Documentation for Pre-Trained Models | Open Model Zooリポジトリで利用可能な事前トレーニング済みモデルのドキュメント |

プラットフォーム

ハードウェアの制限

- 6th-10th Generation Intel® Core™ processors

- Intel® Xeon® v5 family

- Intel® Xeon® v6 family

- Intel® Movidius™ Neural Compute Stick

- Intel® Neural Compute Stick 2

- Intel® Vision Accelerator Design with Intel® Movidius™ VPUs

OS

- Microsoft Windows* 10 64-bit

ソフトウェア

- Microsoft Visual Studio* with C++ 2019, 2017, or 2015 with MSBuild

- CMake 3.4以上 (64-bit)

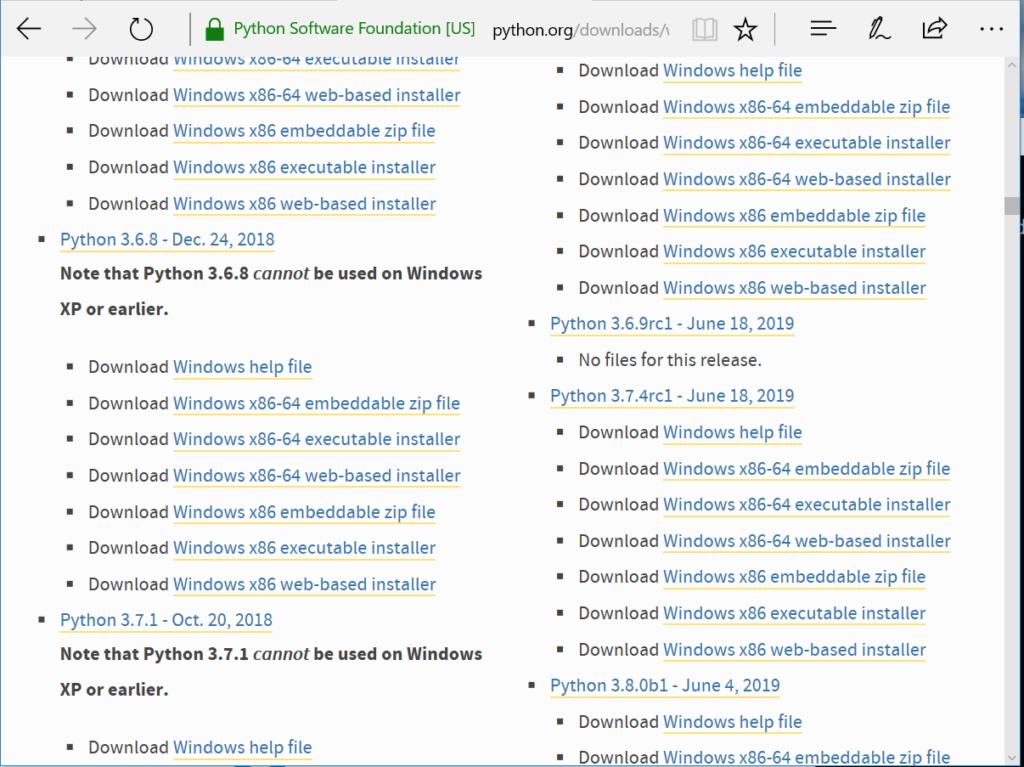

- Python 3.6.5 (64-bit)

※このページでは3.6.8 64bitを使用しました。

インストール手順

Install the Intel® Distribution of OpenVINO™ toolkit Core Components

- Intel® Distribution of OpenVINO™ toolkitを未だダウンロードしていない場合は、 最新版をダウンロードしてください。デフォルトではダウンロードフォルダに

w_openvino_toolkit_p_<version>.exeというファイル名で保存されます。 - ダウンロードフォルダに移動します。

w_openvino_toolkit_p_<version>.exeをダブルクリックします。インストール先とコンポーネントの選択のウィンドウが表示されます。デフォルトのインストール先は、C:\Program Files (x86)\IntelSWTools\openvino_<version>です。C:\Program Files (x86)\IntelSWTools\openvinoのショートカットも作成されます。- Nextを選択します。

- 情報収集に関する選択が聞かれるので選択します。その後、Nextを選択します。

- 動作に必要なコンポーネントが不足している場合、画面上に表示されますが、ここでは何もしなくても大丈夫です。OpenVINO™ toolkit コアコンポーネントをインストール後、不足しているコンポーネントをインストールしてください。※不足のコンポーネントが複数ある場合、忘れないためにメモや写真を撮っておくと良いかもしれません。

- Nextを選択します。

- コアコンポーネントのインストール完了の画面が表示されます。

- Finishを選択し、インストールウィザードを終了します。

- 不足しているコンポーネントがある場合、次のステップに進む前に必ずインストールしてください。全てのコンポーネントのインストールが終わったら、次のステップに進みます。

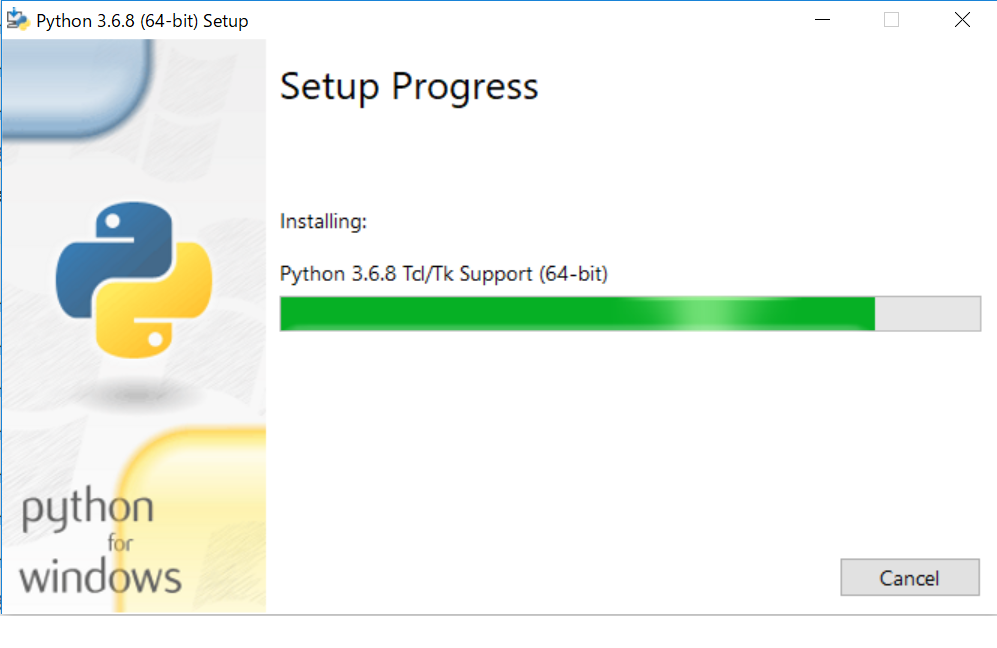

Pythonのインストール

ここでは、Python 3.6.8 x86-64のインストーラを利用しました。

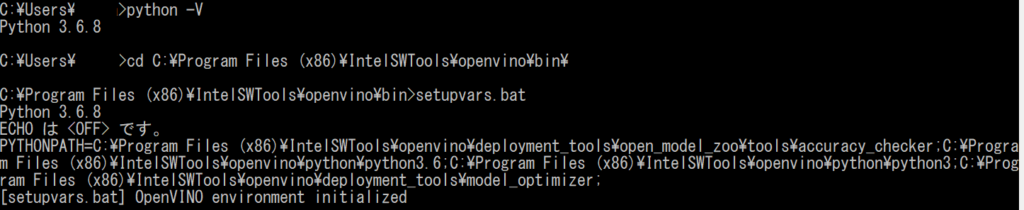

環境変数の設定(一時的)

OpenVINO™アプリケーションをコンパイルおよび実行する前に、環境変数の設定が必要です。コマンドラインを開き、setupvars.batを実行すると、環境変数に一時的に設定されます。永続的に環境変数に設定する場合は、後述の手順が必要です。

cd C:\Program Files (x86)\IntelSWTools\openvino\bin\

setupvars.bat

Model Optimizerの構成

Model Optimizerは、Intel® Distribution of OpenVINO™ toolkitの主要コンポーネントです。Model Optimizerを使用してモデルを実行しないと、トレーニング済みモデルで推論を行うことはできません。モデルオプティマイザーを使用して事前トレーニング済みのモデルを実行すると、ネットワークの中間表現(IR)を出力します。IRはモデル全体を記述するファイルのペアです:

.xml: ネットワークトポロジが記載されているファイル.bin: バイナリデータが含まれているファイル

推論エンジンは、CPU、GPU、またはVPUハードウェア全体で共通のAPIを使用して、IRファイルを読み取り、ロードし、推測します。

Model OptimizerはPython *ベースのコマンドラインツール(mo.py)で、C:\ Program Files(x86)\ IntelSWTools \ openvino \ deployment_tools \ model_optimizerにあります。 Caffe *、TensorFlow *、MXNet *、ONNX *などの一般的なディープラーニングフレームワークでトレーニングされたモデルでこのツールを使用して、推論エンジンが使用できる最適化されたIR形式に変換します。

このセクションでは、スクリプトを使用して、Model Optimizerを、サポートされているすべてのフレームワークに対して同時に、または個々のフレームワークに対して構成する方法について説明します。スクリプトを使用する代わりにModel Optimizerを手動で構成する場合は、「Model Optimizerの構成Configuring the Model Optimizer」ページの「手動構成プロセスの使用」セクションを参照してください。

Model Optimizerの詳細については、Model Optimizer開発者ガイドModel Optimizer Developer Guideを参照してください。

Model Optimizer 構成手順

Model Optimizerは1回でサポートするフレームワークを全て構成するか、その都度構成するかを選択できます。必要に応じて方法を選択してください。ここでは全てのフレームワークを構成する手順を示します。

インストールの確認

インストールが完了した事を確認するために、2つのサンプルのコンパイルと実行を行います。

- コマンドラインを開きます。

- Inference Engine demo ディレクトリを開きます。

cd C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo\ - 次の手順で説明する検証用スクリプトを実行します。

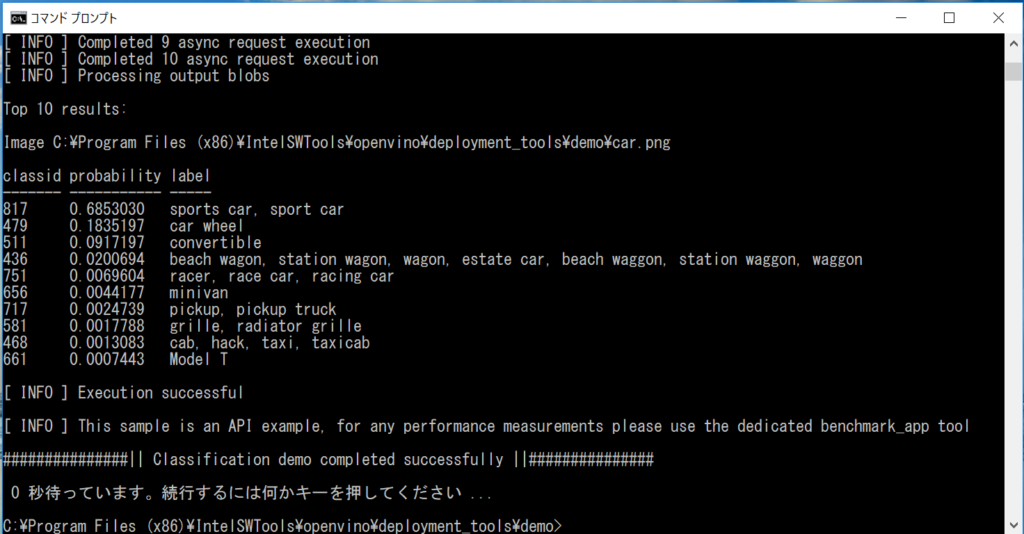

Image Classification Verification Scriptの実行

スクリプトを実行するには、demo_squeezenet_download_convert_run.batファイルを開始します。

このスクリプトは、SqueezeNetモデルをダウンロードし、Model Optimizerを使用して、モデルを.binおよび.xml中間表現(IR)ファイルに変換します。推論エンジンはこのモデル変換を必要とするため、IRを入力として使用し、Intelハードウェアで最適なパフォーマンスを実現できます。 この検証スクリプトは、Image Classification Sample AsyncアプリケーションImage Classification Sample Async をビルドし、demoディレクトリのcar.pngイメージを使用して実行します。中間表現の簡単な説明については、Model Optimizerの構成Configuring the Model Optimizerを参照してください。

検証スクリプトが完了すると、トップ10カテゴリのラベルと信頼度が得られます。

Inference Pipeline Verification Scriptの実行

コンソールでdemo_security_barrier_camera.batファイルを開始します。

このスクリプトは、事前にトレーニングされた3つのモデルIRをダウンロードし、セキュリティバリアカメラデモアプリケーションSecurity Barrier Camera Demoをビルドし、ダウンロードしたモデルとデモディレクトリからcar_1.bmpイメージを使用して実行し、推論パイプラインを表示します。検証スクリプトは、車両属性を相互に構築する車両認識を使用して、特定の属性に絞り込みます。

最初に、オブジェクトが車両として識別されます。この識別は、ナンバープレートを含む特定の車両属性を識別する次のモデルへの入力として使用されます。最後に、ナンバープレートとして識別された属性は、ナンバープレート内の特定の文字を認識する3番目のモデルへの入力として使用されます。

デモが完了すると、次の2つのウィンドウが開きます。

- デモによって実行されたタスクに関する情報を表示するコンソールウィンドウ

- 次のような検出結果が境界ボックスとしてレンダリングされた結果のフレームを表示する画像ビューアーウィンドウ。

ウィンドウを閉じてデモを終了します。

検証スクリプトの詳細については、C:\ Program Files(x86)\ IntelSWTools \ openvino \ deployment_tools \ demoのREADME.txtを参照してください。

OpenVINO™事前トレーニング済みオブジェクト検出およびオブジェクト認識モデルの詳細な説明については、OpenVINO™ツールキット事前トレーニング済みモデルの概要ページ Overview of OpenVINO™ toolkit Pre-Trained Models を参照してください。

このセクションで、OpenVINO™ツールキットの概要を理解頂けたと思います。以上でインストール、構成が完了です。

もし、Intel® Processor graphics (GPU), Intel® Movidius™ Neural Compute Stickや、Intel® Neural Compute Stick 2 or Intel® Vision Accelerator Design with Intel® Movidius™ (VPU)を使いたい場合、また、CMake* and Python*をWindows環境変数に追加したい場合は、オプションの手順を行ってください。

続けてイメージの分類サンプルアプリケーションを実行したい場合は、Run the Image Classification Sample Application を参照してください。

オプションの手順

場合に応じて、追加設定を行います。詳細は英語のドキュメントを参照してください。

- Intel® Processor Graphics 上での推論

- Intel® Vision Accelerator Design with Intel® Movidius™ VPUs上での推論

- Windows環境変数へのCMake*、Python*の指定

Intel® Vision Accelerator Design with Intel® Movidius™ VPUs上での推論

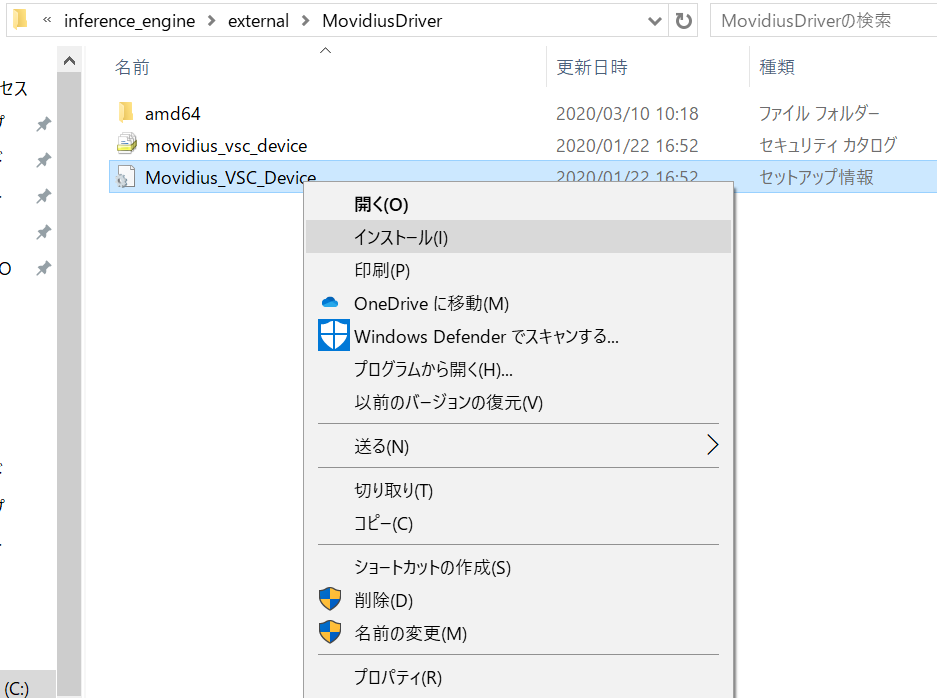

- <OpenVINOインストール先>\deployment_tools\inference-engine\external\MovidiusDriver 配下にある、Movidius_VSC_Device.infを右クリックしてMovidius™ VSC driverをインストールします。

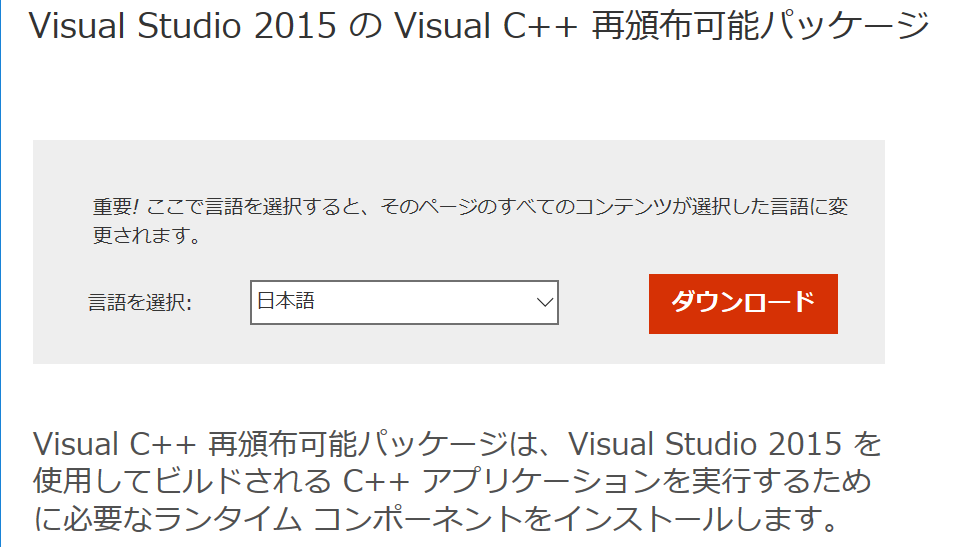

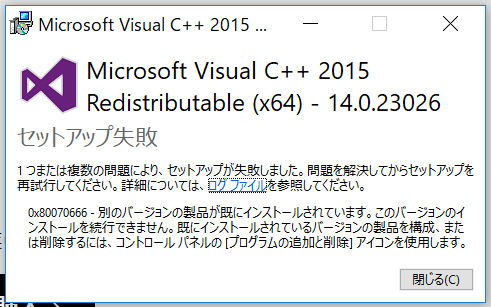

- 次に、Visual C++ Redistributable for Visual Studio 2015 をインストールします。既にインストールされている場合はその旨メッセージが表示されます。

お疲れ様でした。インストールはこれで完了です。

もっとサンプルが実行したい!って場合は、次の記事もお試しください。

フリーのITエンジニア(何でも屋さん)。趣味は渓流釣り、サッカー観戦、インラインホッケー、アイスホッケー、RaspberryPiを使った工作など。AI活用に興味があり試行錯誤中です。